Inhaltsverzeichnis

Modul Basics Audio

Das Modul Basics Audio widmet sich Möglichkeiten der Visualisierung von Musikaufnahmen mit Hilfe von Spektrogrammen. Wie fertige ich ein aussagekräftiges Spektrogramm an? Welche Informationen kann ich aus dieser Visualisierung zur klanglichen, melodischen und rhythmischen Gestaltung der Aufnahme ziehen? Das Tutorial Spektraldarstellungen bietet hierzu eine praktische Einführung anhand eines Klangbeispiels und der freien Software Sonic Visualiser. Hieran knüpft das zweite Tutorial Spektraldarstellung von Gesangsaufnahmen an.

Spektraldarstellungen sind zwar nicht in der Lage, individuelle Hörerfahrungen zu rekonstruieren oder zu erklären. Sie können diese Erfahrungen jedoch illustrieren und somit ihre sprachliche Vermittlung unterstützen. Es handelt sich um einen Zugang über die akustischen Eigenschaften von Klang, die messtechnisch erhoben werden. Dieser Zugang kann einen kulturell orientierten Analyse- und Interpretationszugang zur Musik ergänzen, indem er reichhaltige Informationen zur konkreten klanglichen Gestaltung von Musik zur Verfügung stellt. Außerdem können Spektraldarstellungen als Transkriptionshilfe verwendet werden.

In der folgenden Einführung werden einige grundlegende Informationen zu digitalen Audiodateien und Spektraldarstellungen gegeben.

Grundlagen: Digitalisierung von Musikaufnahmen

Bei der Digitalisierung (Analog-Digital-Wandlung) von Musikaufnahmen wird die Auslenkung des akustischen Signals in regelmäßige Zeitintervallen (Abtastperioden) gemessen. Die Zahl der Abtastungen (sog. Samples) pro Sekunde wird Abtastrate (sampling rate) oder Abtastfrequenz fs genannt. Die Frequenz fs/2 (Nyquist-Frequenz) ist die obere Grenze des darstellbaren Frequenzbereichs; höhere Frequenzen „fallen durchs Raster“ der Abtastfrequenz.

Die gängige Abtastfrequenz für Audiodateien beträgt 44.100 Samples pro Sekunde - als 44.100 Zahlenwerte in der Sekunde. (Die Wahl dieser Abtastfrequenz hing mit der Filmtechnik zusammen; glücklicherweise ist sie jedoch größer als das Doppelte der oberen menschlichen Hörgrenze von ca. 20.000 Hz). Die Zeitreihen dieser Zahlenwerte sind die Grundlage der Digitalen Signalverarbeitung von Audiodaten, also aller Algorithmen, die aus den Audiodaten bestimmte Informationen herausrechnen (vgl. hierzu das Modul Advanced Audio). Dabei ist zunächst unerheblich, in welchem Audioformat die Audiodaten vorliegen; am gebräuchslichsten sind das unkompromierte wav-Format und das komprimierte mp3-Format.

Verschieden Audioeditoren (z.B. Audacity) und weitere Audio-Software bieten Möglichkeiten, die Audiodaten zu laden, zu visualisieren und zu bearbeiten.

Wellenform und Spektrum

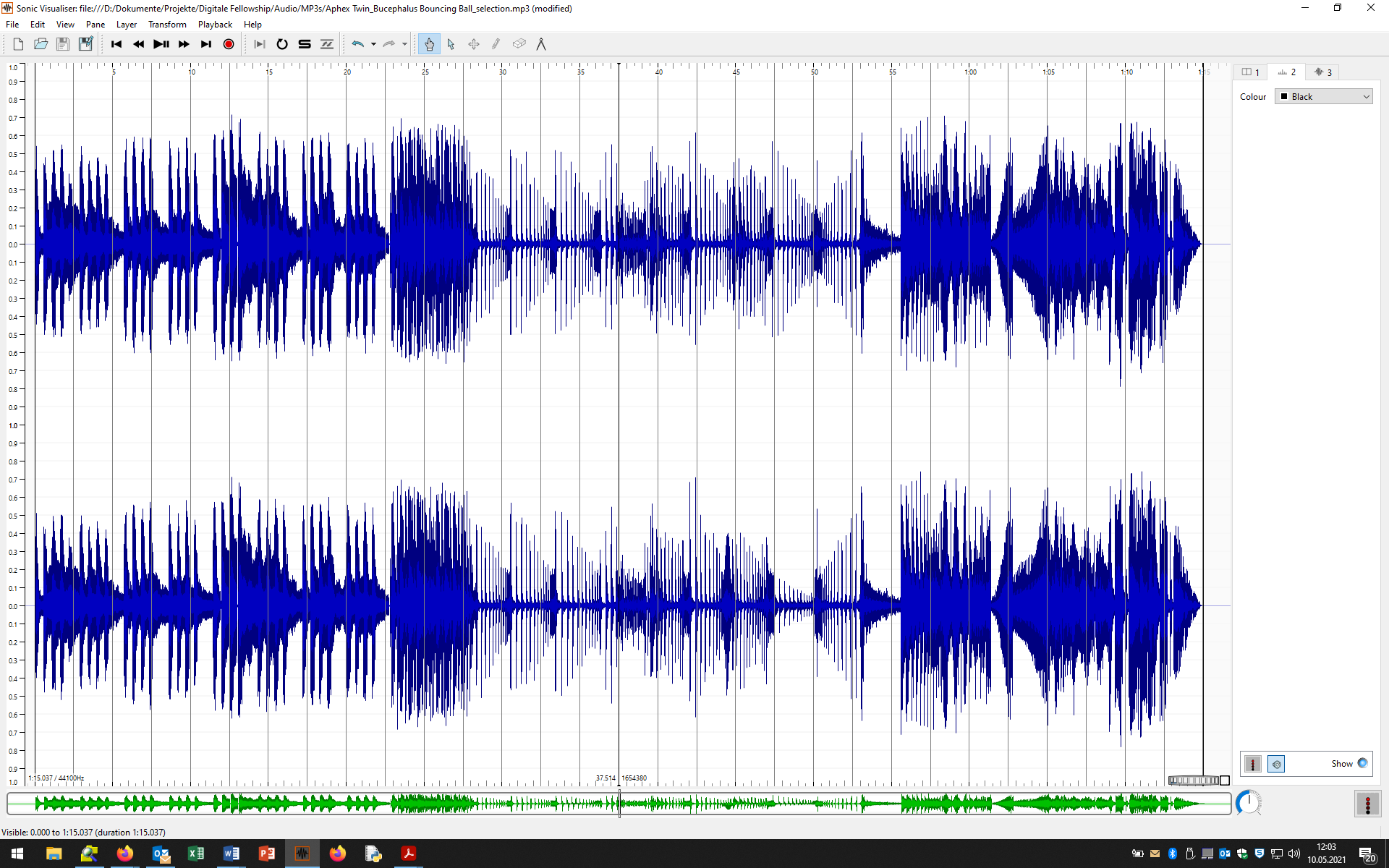

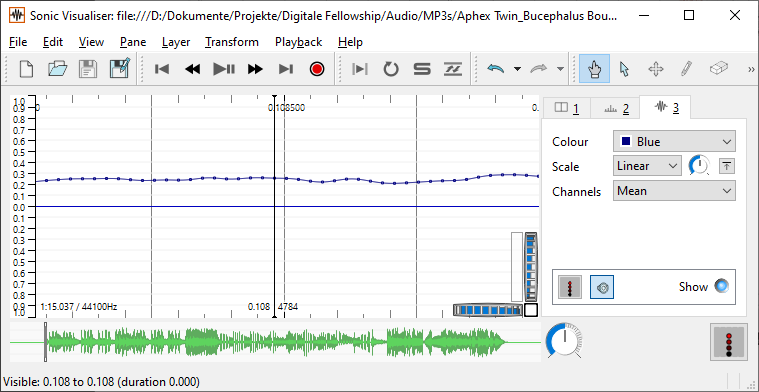

Grundlegend ist dabei die Wellenformdarstellung (s. Abbildung links), in der die Werte der einzelnen Samples im Zeitverlauf dargestellt werden. Wenn Sie sich in eine Wellenform weit genug hineinzoomen, werden die einzelnen Samples sichtbar (s. Abbildung rechts). Beide Abbildungen wurden mit der Software Sonic Visualiser angefertigt.

Durch ein komplexes Rechenverfahren, die sog. Fourier-Transformation (DFT = discrete Fourier transform, STFT = discrete short-time Fourier transform, FFT = fast Fourier transform) kann die Stärke oder Energie der einzelnen Frequenzanteile eines Audiosignals berechnet und als Spektrum dargestellt werden. Ein Spektrum ist eine Momentaufnahme des Klanges bezogen auf ein zumeist sehr kurzes Analysefenster. So ist das Analysefenster in der folgenden Abbildungen nur 4096 Samples, also umgerechnet 93 Millisekunden lang (4096 : 44100 Hz = 0,093 s; Hertz ist der Kehrwert von Sekunde; denn Frequenz/Häufigkeit meint die Anzahl pro Sekunde).

Je nach Größe des Analysefensters wird ein unterschiedlich genaues Spektrum errechnet, was bei stationären Klängen (die sich über die Zeit nicht oder kaum verändern) sinnvoll sein kann. Veränderungen des Klanges bzw. Frequenzspektrums in der Zeit, wie sie ja bei Musikaufnahmen normal sind, werden dagegen nur in einem sog. Spektrogramm sichtbar.

Spektrogramm

In einem Spektrogramm wird

- der zeitliche Verlauf eines Klanges (horizontale Achse) mit

- dessen Frequenzverteilung (vertikale Achse) sowie

- der relativen Stärke der einzelnen Frequenzen (Grau- oder Farbstufen)

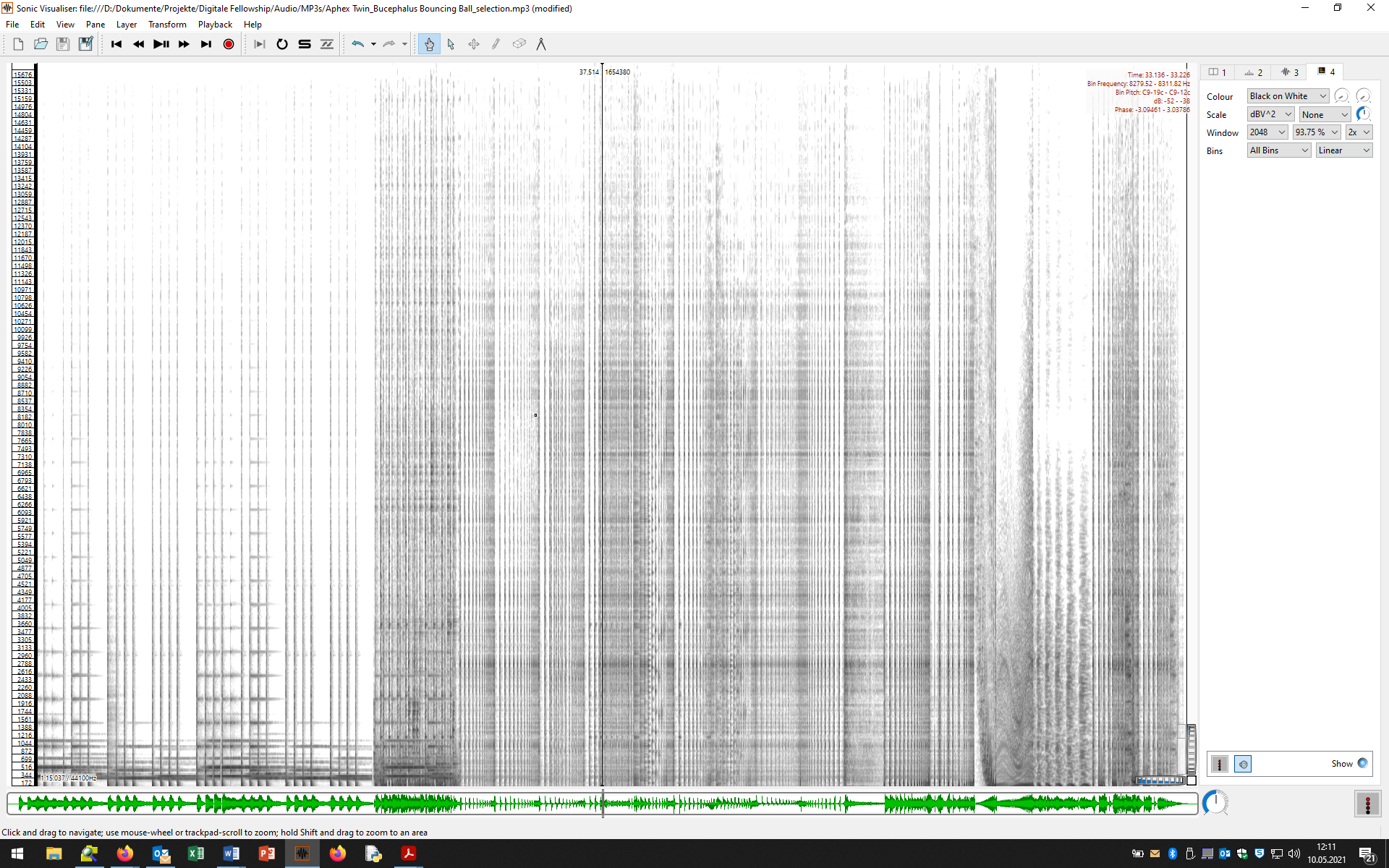

in Verbindung gesetzt. Dabei werden unzählige Fouriertransformationen für aufeinander folgende Audio-Ausschnitte (Analysefenster) durchgeführt und diese Spektren „aneinandergeklebt“. Hier das Spektrogramms einer Aufnahme, die wir im Tutorial: Spektraldarstellung mit dem Sonic Visualiser verwenden.

Grundregeln für die Interpretation von Spektrogrammen:

- Parallele horizontale Linien repräsentieren Klänge mit fester Tonhöhe, wobei die tiefste Linie für den Grundton, die höheren Töne für die verschiedenen Obertöne stehen. Je mehr und je höhere Obertöne ein Klang besitzt, umso heller klingt er.

- Vertikale Linien stehen für geräuschartige, perkussive Klänge, z.B. Schlagzeug-Sounds, da sich das Klangspektrum von Geräuschen bzw. geräuschartigen Impulsen in der Regel über einen sehr breiten Frequenzbereich erstreckt.

- Graue Wolken im Spektrogramm stehen für Rauschen, z.B. Zischlaute im Gesang oder einem ausklingenden Beckenschlag.

Bei der Interpretation von Spektrogrammen müssen immer auch die Eigenheiten der menschlichen Klangwahrnehmung berücksichtigt werden. Denn nicht alles, was man auf einem Spektrogramm sieht, hat ein Korrelat in der auditiven Wahrnehmung. Wichtig sind dabei die folgenden Regeln der Fusion von Klangereignissen und der Integration von Klangsströmen in der Wahrnehmung:

- Frequenzkomponenten, die (annähernd) zum selben Zeitpunkt beginnen und in einem ganzzahligen Verhältnis zueinander stehen, werden nicht als unterschiedliche Klangereignisse wahrgenommen, sondern zu einem einzigen Klangereignis verschmolzen (event fusion). Wir sehen also im Spektrogramm mehrere Linien, hören aber nur einen Klang.

- Klangereignisse, die ähnliche Klangeigenschaften haben (z.B. eine ähnliche Obertonstruktur) und in Bezug auf die Tonhöhe und/oder die zeitliche Folge nahe beeinander liegen, werden ein und derselben Klangquelle und damit einem Klangstrom (musikalisch: einer Stimme, einem Instrument) zugeordnet (auditory stream integration, Gestaltprinzipien der Ähnlichkeit und Nähe).

Wie Sie selbst ein Spektrogramm im Sonic Visualiser anfertigen können und was alles aus einem Spektrogramm herausgelesen werden kann, erfahren Sie im Tutorial: Spektraldarstellung mit dem Sonic Visualiser. Dabei geht es einerseits darum, eine angemessene Visualisierung zu finden für das, was Sie hören. Andererseits können Sie mitunter in der Visualisierung eines Spektrogramms aber auch Details erkennen, die Ihnen die Ohren für Neues und bislang nicht Wahrgenommenes zu eröffnen vermögen.

Vertiefungen

Wenn Sie mehr über Spektraldarstellungen und deren akustischen Grundlagen erfahren wollen, konsultieren Sie bitte eine der folgenden Einführungen:

Stephen McAdams, Philippe Depalle und Eric Clarke: „Analyzing Musical Sound“, in: Empirical Musicology. Aims, Methods, Prospects, hrsg. von Eric Clarke und Nicholas Cook, Oxford 2004, S. 157-196.

Donald E. Hall: Musikalische Akustik. Ein Handbuch, Mainz 1997.

Meinard Müller: Fundamental Music Processing. Audio, Analysis, Algorithms, Applications, New York 2015. Darin: Chapter 2: Fourier Analysis of Signals, online verfügbar in den FMP Notebooks (mit Jupyter-Notebooks zum Nachprogrammieren!)

Interessante Forschungsergebnisse und Hörbeispiel zur auditiven Wahrnehmung und der sog. Auditory Scene Analysis finden sich auf der Website von Albert S. Bregman.

![[Beispiel aus Sonic Visualiser] [Beispiel aus Sonic Visualiser]](/lib/exe/fetch.php?w=400&tok=67086a&media=audio01_screenshot04.png)